II. SISTEMAS DE CAPTURA DE IMÁGENES

| El desarrollo de la tecnología espacial, la electrónica

y los sistemas de comunicación, han diversificado y ampliado la capacidad del hombre para ver mundos inimaginados. |

DE LOS cinco sentidos que posee el hombre, probablemente la visión sea el más importante por la utilidad y satisfacción que proporciona: nos aporta de inmediato un marco de referencia de la posición que ocupamos en el espacio, y nos permite evaluar todo lo que nos rodea de acuerdo a su forma, tamaño y color. Además, como está constituida por un sensor remoto como es el ojo humano y por el cerebro, tal evaluación se puede hacer a distancia, lo que significa que las decisiones y acciones que ejecuta un ser humano, incluso estando en movimiento, están relacionadas con el medio que le rodea; es decir, pueden ser hechas sobre la marcha o desarrollo de una tarea. La emulación de esto por una máquina por medio de un sensor optoelectrónico y una computadora debidamente programada constituye un buen ejemplo de la inteligencia artificial que, plasmada en la robótica, ha facilitado la automatización de muchas tareas en las plantas industriales.

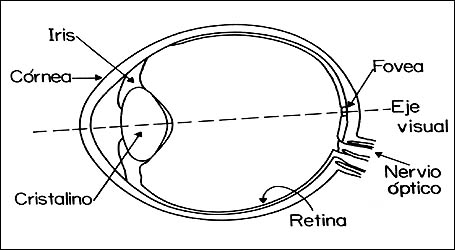

Con base en los conceptos arriba desarrollados puede entonces considerarse

al ojo como el sistema natural para la obtención de imágenes de las escenas

que nos rodean. Este sensor remoto natural está constituido por dos subsistemas

básicos (Figura 7): el de formación de imágenes, representado por el iris y

el cristalino, y el sensor de registro de imágenes, representado por la retina.

Los sensores remotos construidos por el hombre (Tabla 1) contienen también estos

dos subsistemas, pero con ventajas adicionales, puesto que las imágenes generadas

por éstos pueden ser registradas permanentemente, es decir, ser grabadas en

un formato de naturaleza cuantitativa que deja abierto el camino para un análisis

automatizado por medio de computadora. Además, como ya se ha mencionado anteriormente,

estos sensores artificiales permiten "ver" luz no visible por el ojo humano,

ampliando con esto la capacidad de captura de datos y de decisión inteligente

al respecto de éstos.

Figura 7. El ojo humano como sensor remoto natural para la formación

y captura de imágenes del mundo que nos rodea.

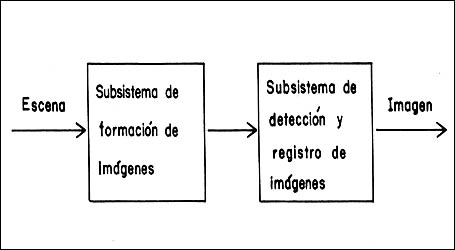

Figura 8. Diagrama de bloques que muestra el proceso de captura

de una imagen por medios artificiales.

A partir de lo anterior, analicemos ahora un sistema artificial de captura

de imágenes. Comenzaremos el análisis por medio de una representación esquemática

en bloques del proceso de captura de una imagen. A su vez, cada bloque puede

descomponerse en elementos básicos, los que, a través de su interrelación, permiten

entender la estructura lógica de un sensor remoto artificial. Para obtener esta

descomposición es necesario introducir ciertos elementos formales a los cuales

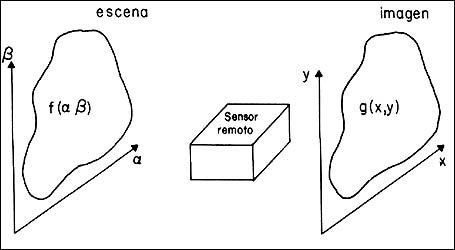

se refieran la escena y la imagen (Figuras 8 y 9). Como puede apreciarse en

las figuras, la escena está representada por una función matemática f(a,b),

que a su vez está referida al sistema de ejes coordenados a(alfa)

y b (beta), los que para un par de valores (a,

b) dan la posición espacial de un punto de ella. Así esta función representa

la variación espacial, es decir punto a punto, de los valores de intensidad

de la luz proveniente de la escena para un color dado. En otras palabras, se

puede decir que si ésta se observa a través de un filtro que deje pasar un solo

color, digamos el verde, entonces f(a,b) proporciona

la variación en tonos de verde de un lugar a otro de ella misma. Puede también

representar los diferentes tonos de gris de una escena en blanco y negro, o

bien, si ésta es vista en pleno color, los diferentes colores que la componen.

Debe quedar claro que f (a,b) se refiere a la escena

independientemente de cómo se le vea, lo que quiere decir que f (a,b)

es una función matemática que la caracteriza y esta función se refiere exclusivamente

a las variaciones de intensidad de luz que provienen de ella, sin embargo estas

variaciones son diferentes de color a color pero propias de cada escena; el

correspondiente filtro sólo las pone de manifiesto.

Figura 9. Subsistema de formación de imágenes.

Por otro lado sabemos que la escena se encuentra iluminada por una fuente y que aquélla refleja o transmite la luz emitida por ésta. Hay que recordar que la escena puede ser al mismo tiempo la fuente de luz, como sucede cuando se desea estudiar al sol mismo, o cuando se pretende obtener la fotografía de un foco encendido. En este caso dicha luz emitida o reflejada es transmitida a través del espacio hasta llegar al sensor remoto, que en la figura 9 se encuentra representado por un paralelepípedo. Este sensor intercepta la propagación de la energía radiante de dicha luz y la transforma de tal manera que en el plano de la imagen se forma la imagen de la escena. Este plano está dado por el sistema de ejes coordenados (x, y) y la imagen por la función matemática g(x, y). En forma análoga a la escena, las coordenadas (x, y) dan la posición de un elemento de la imagen y la función g(x, y) representa la variación en tonos de gris o de color de elemento a elemento de dicha imagen.

Hasta aquí, la imagen dada por g(x, y) se encuentra formada en el plano (x, y), mas no se encuentra registrada o capturada en forma permanente. Así, por ejemplo, al enmarcar una escena por medio de una cámara fotográfica, la imagen correspondiente se encuentra formada en el plano de la película, pero no es sino hasta que el obturador de la cámara es accionado que ésta queda registrada permanentemente, al ser sensibilizada la película por la luz que proviene de la escena y que pasa a través de su sistema óptico. Existen dispositivos sensores en los cuales la formación de la imagen y el registro de la misma se hace por medios fotoeléctricos, es decir, la energía radiante de la luz proveniente de la escena es transformada por el sensor en un voltaje, que a su vez es medido por un instrumento adecuado y que es el que registra en forma permanente su valor. En este caso el proceso ya no es tan evidente ni tan visual como en el ejemplo anterior, pero, sin embargo, constituye un método mucho más eficiente y cuantitativo que el de la fotografía. A estos dispositivos fotoeléctricos se les denominan sensores no fotográficos o bien sistemas optoelectrónicos.

Analicemos con más detalle este último método. Para ello es necesario referirnos

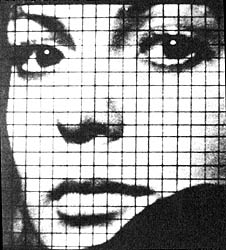

a la sucesión de fotografías de la figura 10. La escena está representada por

la figura l0 (a), la que por simplicidad en esta discusión se muestra sólo en

distintos tonos de gris. Más aún, aunque sabemos que una fotografía está formada

siempre por diminutos puntos de diferentes tonalidades, hagamos una idealización

y supongamos que esta escena es continua, es decir, pensemos que los puntos

son infinitamente pequeños. El proceso se da entonces de la siguiente manera:

a la escena original se le sobreimpone una rejilla cuadrada (Figura 10(b)) que

la subdivide en porciones iguales. Esta rejilla, de hecho, no existe físicamente

en la práctica, sino que más bien representa una subdivisión virtual y que aquí

se muestra para ilustrar el proceso de creación y registro de una imagen. También

cabe aclarar que no necesariamente debe ser cuadrada, hay casos especiales en

situaciones complejas de la investigación en donde puede ser rectangular o circular.

Ahora bien, sobre cada cuadro de la rejilla se efectúa un promedio de los tonos

de gris en relación al área proporcional que ocupan dentro del cuadrado sujeto

a observación, con lo que se obtiene un cuadrado homogéneo (Figura 10(d)), es

decir de un solo tono de gris. Esto que hacemos en forma cualitativa y aproximada

es precisamente la tarea que ejecuta el sensor optoelectrónico: recibe la energía

luminosa de dicho cuadrado, la integra, la promedia y proporciona una medida

de ella a distancia. El siguiente paso es la construcción de una tabla de tonos

de gris, de tal manera que al tono más claro (el blanco) le asociamos el número

0 y al más oscuro (el negro) el número 7, es decir 8 tonos en total. Por tanto,

a los matices intermedios les tocan los números correspondientes entre el 0

y el 7. Esta escala puede ser más amplia: de 0 a 15, o de 0 a 31; pero eso sí,

siempre en múltiplos de dos, puesto que las computadoras trabajan sobre la base

del número dos. Dado que el ojo humano no puede distinguir más de 16 tonos de

gris, dicha coloración entre tonos y números no podrá efectuarse manualmente

para más de 16. Es por esto que un sensor remoto no sólo permite realizar la

digitalización de la escena en una forma extremadamente rápida, sino también

la separación de un gran número de tonos.

Figura 10(a). Escena representada aquí a manera de ilustración

en tonos de gris.

Figura 10(b). Imagen de la escena a la cual se le ha sobreimpuesto una rejilla para el registro permanente por dispositivos fotoeléctricos.

Figura 10(c). Registro numérico de la imagen detectada y registrada por el sensor fotoeléctrico.

Figura 10(d). Representación visual de la imagen digital a través

de una escala de niveles de gris.

Al ejecutar el proceso de integración de los tonos de gris sobre cada cuadrado de la rejilla y comparar cada vez el resultado con la escala de gris previamente establecida, se obtiene entonces una colección de números arreglados en forma matricial (Figura 10(c)), que son, por una parte, la representación numérica de la escena y, por otra, la estructura de la imagen digital correspondiente. Es claro que esa representación numérica es adecuada tanto para efectos de almacenamiento en computadora, como para realizar un análisis cuantitativo de la escena por medio de algoritmos computacionales, los cuales pueden llegar a ser muy complejos, además de permitir el transporte y el envío de datos correspondientes a la escena, no sólo de una manera eficiente, sino a muy larga distancia, como ha sucedido en el caso de las sondas espaciales que recién han explorado el sistema solar: han sido capaces de enviar imágenes de casi todos los planetas y de sus respectivos satélites.

El proceso inverso a la digitalización de una escena puede llevarse a cabo, y de hecho se realiza, en muchas de las etapas de la investigación en percepción remota. A este proceso inverso se le conoce con el nombre de reconstrucción y con él se obtiene una representación visual aproximadamente continua de la escena. Desde luego, la escena misma, que forma parte de la naturaleza, no se puede reconstruir a partir de la imagen. La representación se hace de la siguiente manera: utilizando la misma escala de grises con la que se digitalizó la escena, cada número de la representación numérica se usa para plasmar un cuadrado cuyo tono de gris corresponde al número en cuestión, de tal manera que se obtiene una representación visual (Figura 10(d)) de la imagen digital. Nótese que esto implica que ésta puede tener una representación numérica o una representación visual (reconstrucción de la escena) y que en algunos casos pueden existir ambas. En otras palabras, la imagen digital es una simplificación de la escena con dos posibles representaciones: numérica y visual.

En el ejemplo de las figuras l0(a)-l0(d) el tamaño del cuadrado de la rejilla se ha escogido relativamente grande y en consecuencia se han perdido los detalles más finos de la escena. Para preservarlos en la imagen digital es necesario escoger el cuadrado con un lado tal que sea de por lo menos la mitad de las dimensiones del detalle más fino de la escena. Este cuadrado define, pues, la resolución de la imagen digital y se le conoce con el nombre de elemento de resolución o campo instantáneo de vista (CIV). Es también un elemento físico con dimensiones físicas sobre la escena, a diferencia del número correspondiente en la imagen digital de un campo instantáneo de vista, que constituye un elemento lógico en la representación numérica de aquélla. A este elemento lógico se le conoce como pixel y de por sí no tiene dimensiones físicas, sino que éstas son asignadas de acuerdo a una escala predeterminada en la representación visual de la imagen digital. En resumen, el pixel es la representación numérica o lógica del campo instantáneo de vista y es la medida de la energía promedio que proviene de dicho campo; a cada pixel le corresponde sólo un campo y viceversa. El tamaño del campo instantáneo de vista define la resolución espacial, es decir da el grado de detalle que se puede discernir de la escena, que es a lo que se llama digitización; a su vez, la escala de grises define el número de tonos discernibles y el de la resolución radiométrica, es decir proporciona una medida de qué tanto se puede distinguir una energía luminosa de otra. Recordemos que el ojo humano puede reconocer 16 tonos de gris o bien 16 diferentes niveles de energía luminosa integrada por todos los colores, esto es, sin haber sido filtrada por algún filtro de color. A esta resolución radiométrica se le conoce como cuantización. Estos conceptos, la digitización (resolución espacial) y la cuantización (resolución radiométrica), definen globalmente la calidad de una imagen digital, es decir, dan el grado, parecido o resemblanza con la escena, o la fidelidad con la cual la imagen digital representa adecuadamente a la misma. Este grado de fidelidad o calidad es subjetivo, puesto que para ciertas aplicaciones no se requiere de una gran resolución, además de que digitalizar y cuantizar a un gran detalle implica la generación de un volumen de datos que puede ser innecesario o inconveniente. Por lo tanto, la calidad de una imagen digital se define más bien en una aplicación específica, y la obtención de una calidad superior a la necesaria, o puede no tener sentido, o resultar ser poco práctica en la realidad experimental. Hay que agregar a esto que la calidad de una imagen digital depende también del contraste y del grado de definición de las líneas y cambios de tono presentes en la imagen.

De acuerdo al desarrollo que ha tenido la percepción remota se puede asegurar

que la representación numérica de la imagen digital está enmarcada en un contexto

lógico, muy adecuado para el análisis matemático de los datos respectivos, a

través de programas computacionales, que a su vez representan un determinado

análisis que se desea ejecutar sobre ella. Por otro lado, la representación

visual de la imagen digital es adecuada no sólo para realizar una inspección

sobre la imagen, sino también para la creación de mapas o de registros permanentes

que fungen como referencias básica para la comparación entre los diferentes

aspectos de la evolución de una escena. En general, ésta se realiza después

de haber ejecutado uno o varios pasos del análisis matemático sobre la representación

numérica.

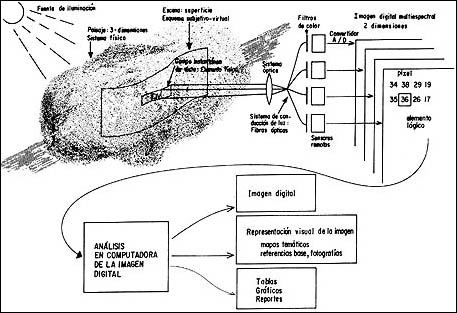

Figura 11. Diagrama lógico de la captura, registro y análisis

de imágenes en la percepción remota.

Una vez introducidos los conceptos anteriores estamos preparados para ampliar

el esquema de captura y análisis de datos de una escena determinada. Para esto

consideraremos el diagrama mostrado en la figura 11, el cual constituye una

representación lógica del diagrama mostrado en la Figura 1. Entonces, el objetivo

de estudio y principio del análisis en percepción remota es precisamente el

paisaje, sistema físico tridimensional, iluminado por una fuente de iluminación.

Por medio del paisaje se encuentra la escena, superficie de carácter subjetivo

virtual, sobre la cual se encuentran los objetos de interés. Esta superficie

puede encontrarse en cualquier parte del paisaje y puede tener cualquier tamaño,

siempre y cuando se encuentre totalmente contenida en lo que se considere como

tal. Sobre la escena se define un elemento con dimensiones físicas, denominado

campo instantáneo de vista (CIV), cuyo tamaño depende de las dimensiones

del paisaje, de la resolución del sensor remoto y de la distancia de éste al

CIV. En otras palabras, el tamaño del campo depende de la geometría

particular paisaje/escena/sensor y de la eficiencia de este último. La energía

luminosa reflejada o emitida por el CIV incide entonces sobre el

sensor optoelectrónico, compuesto en primera instancia por un sistema óptico

(generalmente un telescopio) y por un conjunto de dispositivos de conducción

de luz que hacen llegar a ésta directamente hasta un juego de filtros de color.

Todo esto con el fin de observar simultáneamente la escena a través de ellos,

de tal manera de registrar una imagen digital por cada filtro, y medir posteriormente

sus características. En el caso de radiación corpuscular, como protones o electrones,

en lugar de filtros de color se utiliza un espectrómetro para seleccionar la

energía del haz de partículas empleado en la formación de la imagen digital.

Esto es similar a que se tomaran una sucesión de fotografías de la misma escena,

pero cada vez interponiendo un filtro diferente; el resultado sería un juego

de fotografías mostrando aspectos diferentes de la misma. Esto es muy importante,

pues cada objeto de la naturaleza tiene su muy particular manera de manifestarse

cuando es visto bajo diferentes filtros de color, o bien cuando es bombardeado

con partículas de diferentes energías. Para ahondar más en estos concepto supongamos

que tenemos una escena cualquiera y que, siguiendo los pasos de las figuras

l0(a)-l0(d), construimos un conjunto de cuatro escalas de tonos de color, en

forma análoga a como lo hicimos en la de 16 niveles de gris. De esta manera

tendríamos una escala con 16 tonos de verde, otra con 16 tonos de azul y dos

más con tonos de amarillo y rojo. Sobreponemos entonces una rejilla a la escena

y, observando a través de un filtro verde, hacemos el promedio sobre el CIV

correspondiente, comparamos el resultado con la escala previamente construida

y asignamos, en consecuencia, el número que le corresponde al tono de verde

así obtenido. Repetimos el proceso sobre el mismo CIV pero con

los otros filtros y escalas del resto de colores y obtenemos los números correspondientes;

así, a un mismo CIV le asignaremos cuatro números; uno por cada

color. ¿Qué quiere decir todo esto? Que si en dos CIV diferentes

se encuentran objetos diferentes, entonces se obtendrán dos diferentes juegos

de cuatro números. Este proceso puede generalizarse, pudiendo utilizarse tantos

filtros de color como se requieran, incluso en "colores" como el ultravioleta

y en el infrarrojo que son invisibles al ojo humano, pero que pueden ser detectados

por un sensor remoto moderno. En conclusión, entonces, se obtendrán para una

misma escena tantas representaciones numéricas como filtros de color se hayan

empleado, es decir que si se emplearon cuatro filtros, se obtendrán cuatro imágenes

digitales o si se utilizaron siete filtros, se registrarán siete imágenes digitales.

Resumiendo esto de una manera lógica se puede decir que al conjunto de imágenes

digitales (cuatro o siete) se les denomina "imagen multiespectral" y al conjunto

de números para cada CIV se les conoce como "firma espectral" (Figura

12; véase el pliego a color). De ahí que una imagen multiespectral esté formada

por un conjunto de imágenes digitales, cada una de ellas conteniendo aquellos

aspectos de la escena que corresponden a un color determinado y que, a su vez,

la firma espectral contenga las características del conjunto de objetos que

se encuentran en el CIV, para cada color empleado en la observación

correspondiente de la escena.

Regresemos ahora a la figura 11. Es claro que para registrar simultáneamente los diferentes aspectos de una escena se requieren no nada más diferentes filtros sino también varios sensores: al menos uno para cada color. En el proceso de observación de la escena, cada sensor genera una imagen digital y el conjunto de sensores, por tanto, una imagen multiespectral, la que a su vez queda registrada permanentemente en algún dispositivo de memoria, como por ejemplo una cinta magnética. Una vez teniendo la imagen multiespectral de una escena dada, almacenada en un dispositivo de memoria digital, se puede entonces proceder a la manipulación de estos datos para la extracción de la información deseada acerca de la escena. Al manipular la imagen correspondiente se generan nuevas imágenes digitales que pueden, o bien ser almacenadas en la memoria de la computadora, o bien ser impresas en tonos de gris o de color de acuerdo a la forma de representación visual de una imagen digital ya descrita anteriormente. La extracción de información a partir de una imagen multiespectral puede arrojar conocimiento nuevo que no necesariamente esté en forma de imagen; puede ocurrir que se obtengan reportes de tipo estadístico, tablas o gráficas. Por ejemplo, se puede desear obtener el número de células de una imagen de un microscopio de laboratorio o la distribución de áreas de un conjunto de lagos a partir de una imagen satelitaria. Los resultados del análisis en la investigación en percepción remota pueden ser igualmente válidos, o más bien complementarios, ya sea en su representación visual o en forma de tablas y reportes. Cabe agregar aquí que al sistema optoelectrónico formado por un conjunto de filtros y detectores se le conoce como barredor multiespectral.

La formación simultánea de varias imágenes de la misma escena requiere de un

diseño avanzado para los sistemas de percepción remota, puesto que es necesaria

la adquisición, no nada más de la respuesta espectral de cada CIV

de la escena, sino también de una resolución espacial y temporal adecuadas a

una gran variedad de aplicaciones, por lo menos en lo que se refiere al medio

ambiente geofísico y en lo que concierne a la prospección de los recursos naturales

del país. Para realizar esto se requiere, además de detectores de alta eficiencia,

de toda una metodología en la adquisición de datos a distancia. Esto es así

porque en los sistemas de percepción remota espacial y aerotransportada la velocidad

relativa entre el sensor remoto y la escena es muy alta, lo que impide al sensor

capturar la energía que proviene de cada CIV durante un tiempo

relativamente grande. Lo mismo sucede en sistemas donde el sensor está estático

con respecto a la escena, como es el caso de un sistema de radiografía por medio

de rayos X, ya que aquí se desea que la captura de la imagen sea rápida, de

tal forma que el tiempo que se invierte en medir cada CIV sigue

siendo muy pequeño. Es conveniente decir en este punto que al tiempo que le

lleva al sensor remoto medir la energía del CIV se conoce como

tiempo de residencia o tiempo de integración y que, en general, se desea que

sea lo más corto posible, tanto por los factores arriba mencionados, como porque

existen situaciones de la investigación experimental donde la escena puede estar

cambiando rápidamente, como sucede en el caso de un cultivo de bacterias. Es

claro entonces que el sensor remoto debe responder rápidamente a la energía

luminosa proveniente del CIV y debe operar también en niveles de

ruido muy bajos, así como operar en general a niveles muy altos de eficiencia.

Hemos estado discutiendo hasta este momento el esquema global para la adquisición de imágenes simultáneas de una misma escena por medio de un dispositivo llamado barredor multiespectral; veamos ahora los cuatro diseños fundamentales de barredores de este tipo, discutiendo en cada caso las ventajas y desventajas de cada diseño e identificando los sistemas operativos actuales.

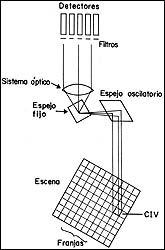

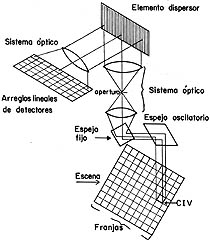

Para esto refirámonos a las figuras 13(a)-13(d) donde se muestran esquemáticamente

los cuatro diseños mencionados. El barredor multiespectral (MSS)

y el mapeador temático (TM) a bordo de los Landsat 4 y 5

1

son los ejemplos más relevantes de la configuración mostrada en la figura 13(a)

y constituyen los baluartes más avanzados de la serie de sensores orbitales

Landsat (Tabla 4) diseñados para el estudio de la superficie terrestre con fines

de prospección de los recursos naturales. Los barredores de los Landsat son

sistemas optomecánicos compuestos por un determinado grupo de fotodetectores,

los cuales, por medio de un espejo oscilatorio, "barren" un conjunto de seis

franjas perpendiculares a la dirección de movimiento del satélite. En un momento

dado, la luz, proveniente de seis

1

son los ejemplos más relevantes de la configuración mostrada en la figura 13(a)

y constituyen los baluartes más avanzados de la serie de sensores orbitales

Landsat (Tabla 4) diseñados para el estudio de la superficie terrestre con fines

de prospección de los recursos naturales. Los barredores de los Landsat son

sistemas optomecánicos compuestos por un determinado grupo de fotodetectores,

los cuales, por medio de un espejo oscilatorio, "barren" un conjunto de seis

franjas perpendiculares a la dirección de movimiento del satélite. En un momento

dado, la luz, proveniente de seis CIV colocados sobre las franjas

y en la dirección de movimiento del satélite, es reflejada por el espejo oscilatorio,

el cual la envía a un sistema óptico formado por un espejo reflector, que en

su plano focal tiene un conjunto de fibras ópticas que transmiten la energía

luminosa sin modificación hasta un grupo de 24 detectores para el MSS.

Enfrente de cada cuatro detectores hay un filtro diferente que define cuatro

planos de color y de esta manera se captura en forma simultánea la respuesta

espectral de seis CIV en cuatro bandas diferentes. En otras palabras,

se van creando cuatro imágenes digitales, una para cada filtro; a cada una de

estas imágenes se le llama banda espectral o plano de color. A medida que se

mueve el espejo oscilante, la luz reflejada por los siguientes grupos de seis

CIV es transmitida por el sistema óptico hasta los detectores;

de ahí que, con la mitad de una oscilación del espejo, se mide la respuesta

espectral de todos los CIV del conjunto de seis franjas que yacen

sobre la escena o superficie terrestre. Para el TM el proceso de

medida es el mismo; sin embargo, el grupo de detectores es de 42, puesto que

se barren seis franjas en siete planos de color diferentes, siendo el tamaño

del CIV de 50 x 50 m² para el MSS y de 30 x 30

m² para los primeros seis planos del TM y para el séptimo,

120 x 120 m2. Los satélites Landsat han producido una gran cantidad

de datos sobre la mayor parte de la superficie terrestre en todas las épocas

del año.

Figura 13(a). Medida en varias bandas de un CIV a la vez.

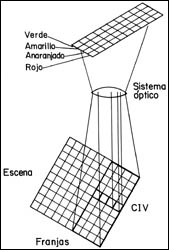

Figura 13(b). Medida de varios CIV, cada uno en diferentes bandas.

Figura 13(c). Arreglos lineales de detectores para medir en varias

bandas un CIV a la vez.

(Figura 14; véase el pliego a color). Estos satélites han sido los primeros en operar rutinariamente y en proporcionar en forma regular datos de gran valor para la comunidad científica, de tal manera que los resultados que se han generado a partir de tales datos han hecho que se impulse la percepción remota a escala mundial, siendo actualmente varios los países que ya cuentan o están desarrollando sus propios satélites. El ímpetu que imprimen estos programas satelitarios a la ciencia de la percepción remota permite actualmente realizar una supervisión rutinaria de varios fenómenos naturales terrestres, así como el de apoyar adecuadamente las labores de exploración a gran escala en relación con los recursos naturales y las actividades del hombre sobre el planeta.

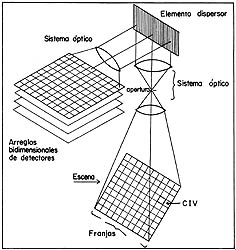

Figura 13(d). Sistema avanzado para medir simultaneamente todos

los CIV de una escena en varias bandas.

Una concepción para aumentar el tiempo de residencia del sensor remoto sobre

cada CIV es utilizar un arreglo lineal de detectores, de tal manera

que haya en esta configuración un elemento detector para cada CIV

de una franja perpendicular a la dirección de movimiento del sensor remoto.

En la práctica se utilizan tantos arreglos lineales para medir la energía luminosa

como bandas se deseen registrar al mismo tiempo. Con este diseño, el tiempo

de residencia se incrementa al intervalo de tiempo que se requiere para que

el elemento detector cruce un CIV a lo largo de la trayectoria

del sensor remoto, lo cual permite reducir el tamaño del CIV y

aumentar, en consecuencia, la resolución. Si se desea utilizar este diseño para

obtener una imagen multiespectral de tres bandas, suponiendo que cada franja

de la escena contiene 1 000 CIV, entonces el número de detectores

requeridos será de tres arreglos lineales de 1 000 elementos sensores cada uno,

es decir 3 000 detectores en total. Este instrumento espectral se conoce con

el nombre de barredor multiespectral modular de tipo optoelectrónico y ha sido

probado en forma experimental a bordo del transbordador espacial en una versión

de dos bandas, y ya ha sido puesta en órbita recientemente por Francia a bordo

de un satélite llamado SPOT (Sistema Probatorio de Observación

de la Tierra); una de tres bandas, con una capacidad para medir CIV

de 20 x 20 m². Al referirnos a la figura 13(b) podemos clarificar aún más

la operación de este tipo de barredor multiespectral. Supongamos que se desea

registrar una imagen multiespectral de cuatro bandas o planos de color correspondientes

al verde, amarillo, anaranjado y rojo, de tal manera que se requiere de cuatro

arreglos lineales de detectores, cada arreglo con los filtros adecuados para

seleccionar los colores mencionados. Consideremos ahora cuatro franjas sobre

la escena perpendiculares al movimiento del sensor remoto, constituido en este

caso por los cuatro arreglos lineales de detectores; entonces, sobre la dirección

de movimiento, tomamos cuatro CIV, uno en cada franja de la escena;

así, el primer CIV será medido y asignado al plano de color rojo,

el segundo al del anaranjado, el tercero al del amarillo y finalmente el cuarto

al del verde. A medida que avanza el sensor remoto en su trayectoria, el primer

CIV será ahora medido y asignado al plano de color anaranjado,

el segundo al del amarillo y el tercero al del verde. El arreglo lineal que

tiene filtro rojo estará en este momento listo para medir los CIV que

se encuentran en la siguiente franja sobre la dirección de movimiento del sensor

remoto; en este proceso, cada CIV de las franjas de la escena es

medido secuencialmente por los cuatro arreglos lineales que corresponden a los

planos de color arriba mencionados, por lo que finalmente se obtienen cuatro

imágenes digitales o bien una imagen multiespectral de cuatro bandas de la escena

a medida que el sensor remoto se mueve sobre ésta; es decir, la escena es "barrida"

a lo largo de la dirección de movimiento del sensor remoto y no perpendicularmente

como en el diseño anterior, donde el espejo oscilatorio es el que proporciona

el "barrido" perpendicular sobre la escena.

El tercer diseño que deseamos considerar aquí (Figura 13(c)) es una especie de combinación de los dos anteriores, en donde se utiliza un espejo oscilatorio para "barrer" la escena perpendicularmente a la dirección de movimiento, pero se incorpora un elemento dispersor en lugar de los filtros considerados en los dos primeros diseños. La luz que proviene de la escena es reflejada por el espejo y pasa, a su vez, por un objetivo óptico formado por un cierto conjunto de lentes; éstos, por su parte, la dejan pasar hacia una entrada y un colimador que la concentra sobre el elemento dispersor. Este elemento dispersor, que puede ser un prisma o una rejilla óptica, la separa en los colores que la componen y la envía posteriormente a un conjunto de detectores formados por un arreglo lineal; cada detector de este arreglo recibe la energía correspondiente a cada color, de tal forma que si se desea registrar la escena en cuatro planos de color, se requerirá entonces de un arreglo constituido por cuatro detectores. Desde luego, el diseño de cada detector debe responder adecuadamente a la energía luminosa correspondiente al color considerado, ya que uno que responda bien al verde puede no hacerlo eficientemente para el infrarrojo. Para terminar la consideración de este diseño podemos agregar que en este caso se pueden medir varias franjas a la vez, por lo que si se desea la medición de seis franjas en cuatro planos de color, se necesitarán por tanto seis arreglos lineales de cuatro detectores cada uno.

Pasemos ahora al cuarto y último diseño (Figura 13(d)) que combina de una u

otra manera aspectos de los tres diseños anteriores. En este caso se utiliza

un arreglo lineal con tantos detectores como CIV tenga la franja

de la escena sujeta a medición, obviando con esto, al igual que en el segundo

diseño, la necesidad de un espejo oscilatorio, lo cual resulta ser muy interesante,

pues con esto se constituye una configuración sin partes móviles. Entonces,

la luz de los CIV proveniente de la franja en cuestión es guiada

por un objetivo óptico y posteriormente por un colimador hasta un elemento dispersor

en donde es separada en colores para ser medida y registrada en tantos planos

de color como se desee y se pueda, de acuerdo a las características de los detectores;

por lo que si se quiere una imagen multiespectral de digamos cinco bandas y

las franjas de la escena tienen 1 000 CIV, se requerirán por tanto

cinco arreglos de 1 000 elementos sensores. Cabe aquí puntualizar que, como

se dijo arriba, cada arreglo debe estar construido para responder eficientemente

al color que se le asigne. Con el tremendo desarrollo tecnológico que ha tenido

en los últimos años la industria de los fotodetectores de estado sólido es posible

considerar una variante de este último diseño que actualmente está en operación

experimental a bordo de aeronaves y que probablemente sea la configuración que

se utilice en los próximos años en las plataformas satelitarias. Esta variante

consiste en utilizar un arreglo bidimensional de detectoras para cada plano

de color, con una dimensión igual al número de CIV de cada franja

por el número de franjas en que se haya dividido la escena. Así que si la escena

tiene 1 000 x 1 000 CIV y se necesita hacer mediciones en cinco

bandas, se requerirán por tanto cinco arreglos bidimensionales de 1 000 x 1

000 detectores, es decir un total de 5 000 000 de detectores. Con esta configuración

la escena es registrada en una imagen multiespectral en un tiempo equivalente

al tiempo de residencia, es decir al tiempo que se requiere para medir un solo

CIV de la escena.

En todas las configuraciones discutidas aquí es necesario considerar un sistema

de almacenamiento digital para los datos producto de las medidas hechas sobre

los CIV de la escena; tal sistema es de particular importancia

para el último diseño donde la escena es capturada prácticamente de "golpe".

Al realizar una medida sobre un CIV determinado, la energía luminosa

para un color dado es transformada por el fotodetector correspondiente en un

pulso de voltaje cuya intensidad es proporcional a la energía luminosa incidente;

a su vez, y por medio de un dispositivo electrónico, llamado convertidor análogo/digital

(A/D), dicho voltaje es transformado a un número entero en una

escala que generalmente es de 0 a 127, con lo que un CIV oscuro

emitirá poca energía luminosa y el voltaje correspondiente será de baja intensidad,

con lo que se obtendrá un número cercano al cero. En el desarrollo de este proceso

se va generando una cantidad enorme de números enteros que deben ser almacenados

en algún dispositivo de memoria al mismo ritmo que son producidos. Como el tiempo

de residencia es de una fracción muy pequeña de segundo, la velocidad a la que

son generados estos números es muy grande y por tanto el sistema de almacenamiento

debe operar con una alta eficiencia. En otras palabras, el fotodetector realiza

una medida y ésta debe ser capturada en un tiempo tal que este detector quede

listo para realizar una nueva medida cuando así lo requiera el proceso. Con

un sistema de almacenamiento masivo de memoria controlado por un microprocesador

se puede realizar una especie de barrido sobre cada fotodetector, capturando

el resultado de las medidas al mismo ritmo que se realiza el barrido sobre la

escena; dicho microprocesador no sólo capturará dicha medida, sino que la enviará

al sistema de almacenamiento masivo con un código lógico de orden para que el

pixel generado y almacenado guarde la misma posición relativa al CIV

correspondiente, de otra manera se tendría una especie de rompecabezas en desorden

y sería imposible reconstruir la escena. Cuando la memoria masiva es suficientemente

grande, los datos ahí almacenados pueden ser posteriormente vaciados con un

ritmo relativamente menor a una cinta o un disco magnético donde la imagen multiespectral

capturada por el sensor remoto queda registrada en forma quasipermanente (se

dice de este modo porque la imagen puede continuar en la cinta o en el disco

por un tiempo indefinido hasta que ya no sea de utilidad su almacenamiento).

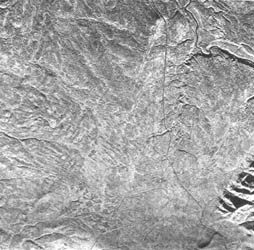

Figura 15. Imagen de radar en donde pueden apreciarse con claridad los rasgos

del terreno, tales como los cauces de los ríos, las montañas y los caminos.

Con el advenimiento de los viajes orbitales por medio de un transbordador espacial es posible, y de hecho varios países así lo han hecho, verificar una serie de diseños de barredores multiespectrales que, convenientemente probados, pueden ser posteriormente montados en una órbita satelitaria para la captura rutinaria de imágenes de la superficie terrestre. En este mismo transbordador espacial se han instalado instrumentos de gran precisión para llevar a cabo diversas misiones relacionadas con la percepción remota y que han sido planeadas con gran antelación. Este es el caso de un radiómetro para medir la energía infrarroja, invisible al ojo humano, con la que es posible identificar una variedad de rocas sobre la superficie terrestre. Se han instalado también sensores remotos para detectar las variaciones de color y temperatura del océano con el objeto de localizar concentraciones de algas y bancos de pesca. Otros detectores cuidadosamente calibrados han sido de utilidad para medir concentraciones de contaminación ambiental en diversas regiones del globo terráqueo. Fue montado también un radar (Figura 15) que ha mostrado el potencial de la percepción remota en la exploración geológica planetaria, además de demostrar la capacidad para estudios rutinarios en la identificación y clasificación de hielo marino, para la medida de la dirección e intensidad del viento oceánico, para la estimación de la cantidad de humedad del suelo y del potencial acuífero de zonas nevadas, todo esto con aplicaciones precisas en diversas áreas de la investigación geofísica planetaria.