II. ¿QUE SON Y CÓMO LOS DESCRIBIMOS?

COMO en casi todas las novelas, todo resulta más comprensible si se comienza por aclarar de qué se trata, sin echar a perder el final. Así, sería apropiado que, como con cualquier personaje principal de una novela decente (cosa que el protagonista no tiene por qué serlo), tratemos de construir su imagen, esbozar su carácter, describir sus pintorescas reacciones, sus variados comportamientos y su lenguaje; en fin, de mencionar todos aquellos aspectos que lo hacen sujeto de escritura y, se esperaría, de lectura.

Como se verá más adelante, el objetivo se logra sólo parcialmente. Resulta que nuestro protagonista no es ni rubio ni moreno, ni alto ni bajo, ni lo uno o lo otro; simple y sencillamente es difícil de acorralar con palabras y escurridizo para manejar. Es más, después de que hablemos de su interesante estructura (digamos, sus raros órganos internos, sus prominentes señas particulares, sus peculiaridades anatómicas y de algunas de sus idiosincrasias y traumas infantiles), resultará que para algunos fines prácticos carece de importancia. Es como si, tras describir minuciosamente el origen de una tormentosa secta a la que pertenece el medio hermano de la heroína, ésta se cambiara de continente y pasara ahí el resto de sus apasionados o bucólicos días, sin relación alguna con los inconfesables crímenes de la susodicha secta. Aun así, un biógrafo meticuloso no dejaría pasar la oportunidad de abordar el mórbido efecto que podría haber causado en su carácter o en sus ocasionales delirios nocturnos.

Advertidos de lo que sigue, mejor es empezar por el principio y entrar en materia, es decir, en fluidos.

II. 1. UNA INDEFINICIÓN PRECISA

La materia, es decir, todo lo que nos rodea y que percibimos a través de los sentidos, viene en tres presentaciones aparentemente distintas y exclusivas: en sólido, en líquido o en gas. Una observación más cuidadosa nos llevaría a pensar que esta clasificación es un tanto simplista y que debiera ampliarse, o cuando menos subdividirse. Así, empezaríamos por organizar las cosas según su textura, color, abundancia, rigidez, etc., hasta llegar al punto en el que cada material quede ubicado y etiquetado correctamente en el nuevo y exhaustivo esquema así elaborado. Este enfoque tendría sus ventajas, pues dada una sustancia con un nombre debidamente asignado (como el piridotín-3-glutaciclina-6-fosfomentasa; le antepongo el artículo "el" porque, de existir, debiera ser masculino), bastaría con buscar en el compendio, por orden alfabético, para encontrar su descripción completa, tal vez una ilustración y las referencias cruzadas a las otras sustancias que comparten una o más características.

En los términos arriba expuestos la tarea parece imposible, si no es que ridícula. Sin embargo, es ésta una de las formas en que se ha procedido y los resultados son sorprendentes. Partiendo de la hipótesis, posteriormente confirmada, de que todo está hecho de un conjunto reducido de elementos básicos que al combinarse, bajo ciertas reglas y en diversas proporciones, da lugar a la impresionante variedad que vemos, los investigadores se dieron a la tarea de aislarlos y caracterizarlos. Ahora contamos ya con obras que resumen el final de esta tarea monumental, considerada una quimera a mediados del siglo XIX, que en su forma más sucinta es la tabla periódica de los elementos de Mendeleev. A pesar de la importancia fundamental de este conocimiento, en cuanto a nuestra comprensión del Universo se refiere, la clasificación no es suficiente para deducir las propiedades de los compuestos que estos elementos forman, ni incluye todo lo que observamos (literalmente, la luz), ni explica cómo un material dado responde y se comporta cuando permitimos a un agente externo influir sobre él. Esto último, el comportamiento dinámico de la naturaleza, exige un tratamiento, un enfoque diferente, más general, universal si es posible, que permita evitar el estudio detallado de cada material, lo que haría del programa científico una tarea inaccesible.

Buscando características genéricas, comunes, y las razones para que éstas se manifiesten, llegamos al estudio de la materia en sus diferentes estados de agregación (formas de presentación), que en última instancia hemos reducido a sólidos y fluidos. Parecería ofensivo el tener que explicar lo que es y lo que no es un sólido. Sin embargo, la separación no siempre es evidente, cuando no inadecuada, al presentar un mismo material con facetas que lo identifican como uno y otro, simultáneamente. Por un lado, a casi todos los compuestos los podemos observar en estado gaseoso, líquido o sólido, como al agua; dependiendo de la presión y temperatura a la que se encuentre, será vapor, agua o hielo. Es posible, y el proceso no es nescesariamente complicado, que un gas pueda licuarse sin cambio abrupto en su comportamiento, observándose una formación paulatina en el gas al ir haciéndose cada vez más denso, hasta ser indistinguible de lo que consideramos líquido. Este hecho es el que nos permite tratar a un mismo nivel, con los mismos criterios, es decir, en forma conjunta, a un gas y a un líquido. Esto no sucede en el proceso de la solidificación de un fluido, o el proceso inverso en el que un sólido se licua o evapora. Hay siempre un punto en el que ciertas propiedades cambian radicalmente al aparecer las dos fases: una sólida y otra fluida, cada una con propiedades ópticas, elásticas, etc., muy distintas.

Supóngase que tenemos un medio homogéneo, es decir, un material cuya composición y propiedades son las mismas en cada parte que lo forma. En cuanto al estado físico en el que se encuentra el sentido común (a veces muy poco común) nos dice que si su carácter es etéreo, terso o escurridizo, el medio no es sólido. Si queremos mantenerlo entre las manos y escapa, se trata de un fluido. Si el medio es sólido podemos retenerlo y es posible deformarlo hasta cierto límite. Un fluido parece no presentar límite a las deformaciones que podemos imprimirle. Estas ideas sueltas que forman parte de nuestra experiencia cotidiana son precisamente las bases para definir a un fluido, si delimitamos un poco más los términos y conceptos incluidos. Aún así, veremos que la naturaleza se las ingenia para exhibir ejemplos que escurren por nuestras definiciones sin dejarse atrapar.

"Un fluido es un material que fluye". Así, además de risa, la definición no da más que pena y sorprendería que pudiera servir para caracterizar a una sustancia. Ahora, hay que precisar lo que es fluir. Para esto vamos a separar en dos a las formas en que actúa una fuerza, que tampoco hemos definido, pero que puede entenderse como el efecto de un agente externo; con buena voluntad y sentido común las cosas usualmente funcionan. Toda fuerza (representada por la flecha en la figura II. 1), al actuar sobre una superficie, puede imaginarse formada de dos partes, una normal o perpendicular a la superficie (N) y otra paralela o tangencial a ésta (T). Cada una de éstas, llamadas componentes de la fuerza, tiene un efecto distinto sobre el material. La componente normal es la que asociamos a la presión y tiende a comprimir o estirar, dependiendo de la dirección de la fuerza. La componente tangencial produce un efecto de deslizamiento relativo entre los planos en que imaginamos estructurado al medio y se le llama también fuerza cortante.

Figura II. 1. Fuerza y su descomposición en componentes normal (N) y tangencial (T).

Para ilustrar esta descomposición de las direcciones y efectos de una fuerza consideremos el siguiente ejemplo. Imaginemos una esponja, de forma regular y pegada a dos vidrios planos en sus caras superior e inferior (Figura II. 2(a)). Si aplicamos una fuerza puramente normal a cada uno de los vidrios (Figura II. 2(b)), la esponja se comprime, reduciendo su volumen pero manteniendo su forma. Si ahora jalamos cada vidrio en dirección opuesta, de modo que la separación entre ellos se mantenga constante, dando lugar a una fuerza de corte sobre la esponja, ésta se deformará manteniendo su volumen (Figura II. 2(c)). Por lo general, una fuerza con una dirección arbitraria produce una mezcla de ambos efectos, dependiendo de la proporción entre su componente normal y su componente tangencial.

Figura II. 2. Esponja (a), fuerzas normales (b) y de corte (c).

Volviendo a nuestro problema original, consideremos un medio sujeto a fuerzas cortantes, como la esponja en el caso (c). Un material que es sólido se deforma hasta cierto límite, rearreglando sus elementos estructurales (átomos) hasta generar una fuerza igual en magnitud, opuesta en dirección a la aplicada, y así quedar en equilibrio; en última instancia, los átomos ligados entre sí por fuerzas de origen electromagnético se ven obligados a cambiar sus posiciones relativas hasta balancear exactamente la fuerza aplicada. La deformación se detiene en el preciso momento en que esto se logra. Decimos que un material es elástico si al retirar las fuerzas aplicadas recupera su forma inicial. Le llamamos plástico si no recupera su estado original y guarda cierta memoria de las fuerzas que sufrió. Una sustancia que bajo la acción de una fuerza cortante, por pequeña que ésta sea, se deforma sin límite se dice que fluye. ¡Un fluido es un material que fluye! Ahora ya no parece tan tautológica la definición. Así, el mar bajo la acción del viento, que produce una fuerza cortante sobre su superficie, se deforma sin límite, se mueve continuamente sin lograr frenar al viento por tenue que éste sea: la deformación resultante es la que percibimos como oleaje, hipnotizando a unos y mareando a otros.

Parecería que con esto se ha logrado clasificar a todas las sustancias en dos grandes grupos. Sin embargo no es así, lo cual hace el punto más interesante. Hay sustancias que tienen un comportamiento dual para las que nuestra definición es inadecuada o insuficiente. Es tal la diversidad de sustancias que la tarea de completar y precisar una sola definición es inútil.

A las rarezas las tratamos en forma especial, en subgrupos, según las circunstancias. Materiales tan familiares como el vidrio, la pintura y el pavimento pertenecen a esta clase exótica de materiales. El vidrio, que se comporta como sólido cuando lo estudiamos en un laboratorio (o cuando una pelota de béisbol es bateada en la dirección equivocada y va a dar precisamente a...), resulta ser un fluido cuando los tiempos de observación son suficientemente largos. Se puede ver en los emplomados de las viejas catedrales góticas que la parte inferior es mucho más gruesa que la superior. La razón es que el vidrio ha fluido, por cientos de años bajo la acción de la gravedad.

También hay sustancias que presentan comportamiento simultáneo de fluido y sólido. Su tratamiento requiere de consideraciones particulares que caen en el área conocida como la reología. Materiales de este tipo, con propiedades que genéricamente son llamadas viscoelásticas, son por lo general soluciones con gran cantidad de partículas (polímeros) disueltas en ellas. Casos típicos son las resinas, los plásticos, múltiples derivados del petróleo y diversos tipos de champú (el aire de la ciudad de México parecería un buen candidato).

II. 2. LOS ÁTOMOS Y LA VENTAJA DE IGNORARLOS

La concepción atomística de la naturaleza, según la cual todas las cosas estan constituidas por elementos indivisibles e inmutables, se remonta al origen de nuestra civilización. Si bien no es sino hasta el siglo XVII que esta imagen adquiere carácter científico, al empezar a ser fundamentada en la experimentación, es notable la semejanza que hay entre las ideas básicas en sus primeras formas y las que hoy en día tenemos.

En la antigua Grecia es donde aparece no sólo la idea general del atomismo, sino las diversas formas que éste adquiere. La existencia de los átomos y del vacío que los rodea, como una necesidad en la explicación de la constitución del mundo, es planteada por razones filosóficas, manteniendo este carácter hasta el renacimiento europeo.

Demócrito, en el siglo V, a.C., es sin duda el representante más importante del atomismo griego. Para él, la naturaleza estaba formada de un número infinito de corpúsculos invisibles por su tamaño, que diferían entre sí sólo en forma, dimensión y estado de movimiento. Comparte con Parménides la idea de un Universo cualitativamente inmutable, pero difiere de éste en cuanto al aspecto cuantitativo, pues atribuye los cambios a la multiplicidad de maneras en que estos átomos se combinan, manteniendo su naturaleza. Así, un cambio aparente en calidad podía ser entendido, al menos en principio, como una variación en la cantidad de átomos que participaban en el proceso.

En la misma época, Empédocles propone la idea de un Universo formado de cuatro elementos básicos, aire, agua, tierra y fuego, que al mezclarse en distintas proporciones generan la inmensa variedad observada. Este modelo, que domina el panorama a todo lo largo de la Edad Media, sin ser atomista en el sentido estricto, refleja la necesidad de reducir a componentes primitivos a la naturaleza. Estas ideas, compartidas y desarrolladas por Platón un siglo más tarde, y la concepción de su discípulo, Aristóteles, en torno a la desaparición de las partes al formar un todo, impidieron el florecimiento y desarrollo del atomismo en la civilización helénica.

Cuando Tito Lucrecio Caro escribe su poema De rerum natura (Sobre la naturaleza de las cosas) en el siglo I, a.C., el atomismo griego es incorporado a la cultura latina, enriquecido en el proceso por Epicuro, su defensor en el siglo III, a.C. Durante los siguientes diecisiete siglos, crisol del renacimiento y etapa de gestación de los principios del conocimiento experimental, las ideas filosóficas sobre este particular se mantienen casi invariables: la materia no puede ser dividida sin límite y sus elementos constitutivos primitivos son inmutables, incontables en número y finitos en su diversidad.

En las décadas alrededor de 1600, mientras Galileo Galilei y Francis Bacon establecen las bases del método científico o experimental, Pierre Gassendi revive el atomismo clásico para una época mas madura. Daniel Sennert y Robert Doyle, aceptando la idea atomista, le dan su verdadera dimensión al buscar su contenido en la experimentación. Así, Boyle logra descartar en forma definitiva el sobresimplificado esquema de los cuatro elementos. Un siglo más tarde, Antoine Laurent de Lavoisier desarrolla la metodología del análisis químico y define en la práctica a los elementos químicos. La generación que le sigue establece los fundamentos de la teoría atómica moderna, con la obra de John Dalton, al identificar elementos químicos con átomos y proponer las formas en que éstos se combinan para formar compuestos.

El atomismo griego, la teoría atómica de Dalton y la idea contemporánea sobre la constitución de la materia, comparten suficientes rasgos como para considerarlos un mismo proceso animal observado en su evolución a través del tiempo; cada etapa muestra los cambios indispensables para alcanzar la madurez. Si bien los átomos, concebidos como constituyentes últimos de la materia, han sido sustituidos por las partículas elementales, como el electrón y el neutrino, se ha mantenido el atomismo que imaginara Demócrito. Por otro lado, se ha perdido el carácter inmutable de aquellos átomos de Lucrecio y de Dalton; los nuevos átomos, en el verdadero sentido etimológico del término, pueden combinarse para disolverse en luz (al reaccionar un electrón con un positrón) o perder su identidad formando un todo (al combinarse un protón, un electrón y un neutrino para formar un neutrón).

Esta búsqueda de la explicación última de la materia en términos de sus componentes más simples ha sido, y es, un esfuerzo por alcanzar uno de los objetivos fundamentales de la física. Creemos tener una idea bastante cercana y correcta sobre estos pequeños bloques universales con los que se construye todo lo que observamos. Otro es el problema de cómo éstos se combinan para formar átomos, éstos a su vez formar moléculas y éstas agruparse para conformar un elote, o un insecto rayado que almacena miel en hexágonos o, lo que resulta más sorprendente, dos mamíferos que se comunican entre sí, uno pinto que ladra, y otro bípedo que lo cuida, circunnavega el planeta y se asombra de todo, hasta de su mismo asombro.

No deja de llamar la atención que lo que damos ya como un hecho, la existencia de los átomos, sea en realidad algo que no se puede intuir fácilmente. Nuestros sentidos son incapaces de percibirlos y lo que nos rodea parece consistir de objetos, sólidos y fluidos, de aspecto terso y continuo. Es difícil imaginar que el humo de un cigarro esté formado de moléculas relativamente complejas o que al aire que respiramos lo componen moléculas simples separadas unas de otras millares de veces la distancia que caracteriza su tamaño. Para tener una idea de las dimensiones atómicas tendríamos que imaginar todo amplificado, de manera que por ejemplo una manzana fuese del tamaño de la Tierra. ¡Un átomo de la manzana sería entonces del tamaño de una canica! Si toda esta concepción es cierta, y todo parece indicar que así es, la tarea de explicar, por ejemplo, el movimiento del agua al salir de un tubo, en términos de átomos, parece equivalente a tratar de construir la Torre de Babel.

El problema de estudiar el movimiento individual de miríadas de partículas para luego predecir su comportamiento conjunto es algo que no tiene que ver con la física; en la práctica el problema no puede ni plantearse, mucho menos resolverse. Sería necesario aplicar las leyes básicas de los átomos, la mecánica cuántica, a cada partícula, y conocer detalladamente todas las fuerzas que actúan sobre cada una, establecer sus posiciones en algún momento y, con las matemáticas usuales, resolver simultáneamente el problema para todas.

En una gota de agua hay 100 000 000 000 000 000 (1017) moléculas de agua aproximadamente, ¡tantas como segundos en la edad estimada del Universo! Sería ridículo intentar escribir las ecuaciones y patético pensar en resolverlas. Nos tomó siglos pasar de una idea filosófica a una concreta que nos permite explicar suficientes cosas como para que su validez esté, por lo pronto, más allá de toda duda razonable. Ahora resulta que el asunto es tan complicado, que la idea es algo enteramente inútil (al menos para estudiar chorros de agua).

La solución de este problema se encuentra en la complejidad del mismo. Suena paradójico, pero con un ejemplo podemos intuir el argumento que siguieron quienes contribuyeron a esclarecer la solución.

Imaginemos un dado perfecto, cada arista de la misma longitud y cada ángulo de 90º. Supongamos ahora que el dado se encuentra parado sobre un vértice, con el vértice diametralmente opuesto sobre una línea vertical, y que nos preguntamos por la dirección en la que va a caer al soltarlo (Figura II.3). Si el lado es perfectamente simétrico, ¡no cae! Se quedará así mientras no sea perturbado. Una corriente de aire o una vibración, por imperceptibles que sean, harán que caiga el dado.

Figura II. 3. Equilibrio de un dado.

Una pequeña variación trae como consecuencia un efecto grande: la caída del dado. Los detalles de la perturbación son casi imposibles de prever y por consiguiente la posición precisa del dado no se puede predecir. Las fuentes que originan estas pequeñas variaciones son diversas, complicadas y difíciles de estimar. Un efecto es siempre el mismo: el dado se cae. Si hacemos una serie de pruebas encontraremos que las direcciones en las que cae están distribuidas sobre un círculo y que las caras que quedan hacia arriba son las tres opuestas al vértice de abajo, apareciendo éstas con igual frecuencia, si el número de pruebas es suficientemente grande. Así, del problema inicial, imposible de resolver, hemos podido encontrar varios aspectos claros y precisos de la solución, quizá obvios o triviales en este caso, pero que nos dicen cosas concretas sobre la caída. En primer lugar sabemos que cae; si esperamos lo suficiente, algo o alguien llegará a importunar la delicada paz del dado. Segundo, el dado no tiene preferencias y cae en cualquier dirección. En tercer lugar, hay tres caras que se reparten por partes iguales el derecho de aparecer arriba.

Este ejemplo ilustra los puntos claves que permiten estudiar la dinámica de un fluido, constituido de un número extraordinario de átomos.

Nuestro sistema, el dado y sus alrededores, todo lo que rodea y afecta al dado, siguen ciertas leyes, las leyes de la mecánica. La aplicación de estas leyes resulta tan complicada que no podemos resolver el problema en la forma originalmente planteada, es decir, predecir en detalle el movimiento del sistema. Si cambiamos el enfoque buscando ahora una descripción cualitativa, más general, es posible entonces responder en forma precisa algunos aspectos de la caída de dados; aspectos de carácter más amplio que no dependen de los minuciosos y abrumadores detalles del proceso. Para esto aceptamos a cambio describir el comportamiento más probable o promedio del sistema, introduciendo un elemento esencialmente nuevo en nuestra descripción: la probabilidad. Esta herramienta, una de las más poderosas que las matemáticas han generado, es ahora un ingrediente fundamental en la física.

Podría pensarse que el precio de nuestra ignorancia o incapacidad es el de conformarse con una descripción más burda, menos exacta, pero no es así. En realidad el problema inicial es irrelevante y en el fondo ni siquiera interesa. Si en el ejemplo del dado pudiésemos resolver un caso en particular, haciendo uso de todo lo que sabemos y una dosis de ingenio, tendríamos precisamente eso, un caso especial. Una pequeña variación y el resultado sería muy distinto (otra dirección y otra cara). Este efecto, en el que un pequeño cambio en el estado inicial produce un resultado final radicalmente distinto, ha introducido más de una sorpresa en nuestro estudio de la naturaleza. Esto es particularmente cierto con los fluidos. Mucho más fructífera ha sido en cambio la búsqueda del comportamiento global, promedio y genérico de un sistema.

No es raro escuchar que cuando se recurre al análisis estadístico o al uso de conceptos probabilísticos es debido a nuestra incapacidad o ignorancia. Sin afirmar que esta posición es ridícula, sí es sólo una parte de la historia; a veces irrelevante. Al promediar muchos detalles se obtiene una descripción completa. En el caso de los gases no es necesario conocer muchos de los detalles atómicos para conocer su temperatura, presión y volumen. Esto es característico del sistema, ¡no de quien lo observa! En todo caso, la tarea del científico es la de explicar cómo y por qué sucede esta maravillosa contracción de la información. Encontrar qué cantidades o propiedades microscópicas son irrelevantes para predecir el comportamiento que observamos es parte de la investigación en curso, si bien contamos con respuestas exquisitas e indicaciones claras de cómo proceder en muchos casos.

La descripción macroscópica de un fluido, es decir, la definición de las cantidades que se usan para caracterizar su estado y las leyes que determinan la variación temporal y espacial de éstas, tiene su fundamento en el comportamiento (dinámica) de las partículas que lo forman. Esto ocurre de tal manera que, al actuar en concierto, cada átomo o molécula pierde su identidad, heredando algunas de sus características a cantidades genéricas o colectivas llamadas coeficientes de transporte, como la viscosidad y la conductividad térmica. Estas etiquetan al fluido, distinguiéndolo de otro de composición diferente.

La teoría que establece la conexión entre este mundo microscópico de átomos y moléculas y el mundo de los fluidos, de chorros y remolinos, es un activo proyecto de investigación en múltiples instituciones académicas en casi todos los países, en particular en México. En el caso de fluidos poco densos, de los gases, la teoría fue construida por James Clerk Maxwell y Ludwig Boltzmann a finales del siglo pasado y desarrollada a todo lo largo del presente siglo; se conoce como la teoría cinética de los gases. El notable éxito logrado en el caso de los gases confirma la viabilidad del programa que busca establecer esta conección en el caso de un fluido arbitrario y fuera de equilibrio.

Desde un punto de vista más práctico, cualquier fluido como el agua o el aire forma una estructura continua y suave al estudiarlo macroscópicamente, es decir en dimensiones mayores a, digamos, décimas de milímetro (0.1 mm = 10-4 m). En un volumen de un cubo de 0.1 mm de longitud por lado, de una millonésima de litro (10-12 m³), hay 7.34 x 1015 (734 seguido de 13 ceros) moléculas de aire, a una temperatura de 27º C ¡y a presión atmosférica! En este volumen, tan pequeño como parece, hay tal cantidad de moléculas que la presencia de unos millones de más o de menos de éstas no afectan de manera apreciable ninguna cantidad medible, aun con los instrumentos más precisos de que se dispone. Estos instrumentos miden cantidades promedio sobre un desorbitado número de partículas, de manera independiente de éste.

En una verdadera escala microscópica los átomos ocupan una fracción muy pequeña del volumen que los contiene, el espacio vacío entre unos y otros ¡es mayor al 99.999... %!, de modo que las propiedades del fluido son muy irregulares, cambiando rápidamente de una región a otra debido al continuo movimiento de las moléculas; no usamos pues esta microescala cuando lo que interesa es entender cómo se vacía un lavabo o se infla un globo.

La hipótesis básica, que es válida para la teoría en todos los niveles, es la llamada hipótesis del continuo. Ésta consiste en suponer que todas las cantidades necesarias para caracterizar a un fluido, como pueden ser su temperatura, su velocidad, su densidad, etc., están bien definidas en cada punto del espacio y varían suavemente de uno a otro, ignorándose así la naturaleza discreta, atómica, del fluido. Por un punto se sobreentiende entonces un volumen muy pequeño, digamos una milésima del considerado en el párrafo anterior, en el que hay un número tan grande de moléculas como para que el promedio de la velocidad no dependa de este número, pero lo suficientemente pequeño como para que pueda verse como un punto por los instrumentos más sensibles y finos.

A partir de ahora dejaremos de lado a los átomos, pues a pesar de su importancia hemos encontrado la ventaja de ignorarlos. Nuestras partículas de fluido tendrán el sentido que dimos a un punto en el fluido. A pesar de la advertencia, volveremos a los átomos en el último capítulo, cuando nos dejemos sorprender por los superfluidos.

II. 3. APEROS: FRASCOS Y TUBOS, IDEAS, MATEMÁTICAS Y... FLUIDOS

El estudio de un fenómeno, o un grupo de ellos, se inicia con una serie de observaciones que permiten apreciar cuáles son los aspectos más importantes, los que gobiernan el proceso. En el fondo, lo que se busca es la forma de simplificar el análisis, aislando las causas que determinan el efecto principal e ignorando aquellas que desempeñan un papel secundario. Establecer cuáles cantidades y la forma en que éstas contribuyen es una parte medular del proceso de entendimiento. Encontrar las razones por las que se combinan de esa manera, usando los principios o leyes correspondientes, es otra etapa igualmente difícil e importante. La última parte, la esencia misma del conocimiento científico, es la predicción. Con base en el estudio previo debe ser posible anticipar el resultado de nuevas observaciones al cambiar de diversas formas el arreglo inicial del fenómeno.

En el esquema anterior está implícito lo que se conoce como método científico. Lejos de ser un procedimiento sistemático y consciente, que lo convertiría en una receta, hermosa, complicada y útil, pero al fin y al cabo una secuencia de pasos bien definidos a seguir, los investigadores intuyen este procedimiento con base en una tradición racional, participando en una o más de estas etapas, omitiendo algunas, ocasionalmente agregando otras y ligados indisolublemente, conscientemente o no, a su entorno social. Lo que sí podemos extraer son algunos de los elementos que parecen siempre estar presentes en una u otra forma en el quehacer científico y en especial en la física; este problema, ciertamente abierto, es materia de la teoría del conocimiento, la epistemología, y ha sido objeto de estudio y reflexión de filósofos e investigadores.

Un primer aspecto es la concepción filosófica que el observador tiene de la naturaleza y del conocimiento que sobre ésta puede adquirir; aquella puede ser explícita o tácita. En este mismo nivel hay una serie de principios filosóficos y de reglas lógicas que el investigador establece, usa y que, normalmente, van implícitas en su trabajo. Así, su contribución diaria puede sobreentender un materialismo que da por hecho la existencia de un mundo objetivo independiente de él, una convicción total en el principio de causalidad que justifica buscar el origen de un efecto, o el uso irrestricto de la lógica clásica, que sin temor al abuso se omiten al discutir de política.

En la parte que toca a las observaciones mismas, empezamos por elaborar un modelo a priori (antes de empezar) sobre el fenómeno al separarlo en partes, el sistema y sus alrededores, y asociarle una regularidad que nos asegure que al repetirse el fenómeno podremos observar y medir lo mismo. Si un resultado no se puede reproducir, por lo general pierde el interés científico, convirtiéndose en un hecho fortuito, objeto de un análisis de otra especie. El llevar a cabo un experimento que "remede en todo" al anterior, tantas veces como sea necesario, es algo que sólo puede lograrse en un laboratorio.

Así, con base en el ingenio, la minuciosidad sistemática, la intuición y la experiencia, como en cada etapa en la dilucidación del fenómeno, se escogen las cantidades relevantes. Acto seguido se determina la forma de medirlas, las posibles fuentes de error y se procede a su cuantificación, estableciendo la consistencia interna y la estadística de los datos obtenidos.

El análisis siguiente consiste en asociar un símbolo a cada cantidad y precisar las posibles relaciones entre éstos, es decir, la forma en que unos dependen de otros. Este proceso lleva a la elaboración de expresiones (fórmulas) que vinculan a los símbolos entre sí, sintetizando grandes cantidades de datos. Las reglas para asociar números a símbolos y para manipular y combinar estos últimos constituye el lenguaje que llamamos matemáticas.

En realidad, las matemáticas son una disciplina teórica que va más allá de un lenguaje o una herramienta, aunque vistas como tales permiten, en manos educadas y hábiles, forjar una imagen abstracta, extremadamente útil y especialmente bella del universo concreto que percibimos. Una virtud de las imágenes así logradas es su capacidad de hablar, a quien las sabe oír, sobre lo que es posible y lo que es probable. ¡Cómo hubiesen aprovechado algo semejante las sacerdotisas del oráculo de Delfos! No siendo de origen divino las predicciones así logradas, como nunca lo fueron las pregonadas por las pitias en Delfos, siempre son sujetas de verificación, a través de más experimentos. Basta con uno de éstos que no corresponda a lo esperado o predicho, para que sea necesario modificar parte de las premisas usadas en la elaboración de la predicción, repitiéndose entonces el proceso. Ha sucedido, por fortuna muy de vez en cuando, que las modificaciones necesarias han ido al mismo fondo de los principios filosóficos.

La física funciona más o menos como lo hemos esbozado. Al construir una teoría se parte de algunos conceptos primitivos que se dejan sin definir o se apela a la intuición para introducirlos, como la masa, el espacio y el tiempo. Después, se definen cuidadosamente cantidades compuestas, como la densidad, la velocidad y la presión, y acto seguido se postulan ciertas proposiciones (basadas en experimentos), los axiomas o leyes fundamentales, como verdaderas y universales. Su inmensa virtud es que, ante la duda, basta con llevar a cabo un experimento para constatar su validez. A partir de los axiomas se deducen entonces una serie de proposiciones o teoremas que, posteriormente, llegan a ser consecuencias no triviales y lejanas de aquellos postulados originales. En muchos casos los teoremas son formulados como conjeturas basadas en la intuición o como resultado de un experimento. El reto en estas circunstancias es encontrar el procedimiento para deducirlo a partir de los axiomas: encontrar la explicación completa del fenómeno a partir de las leyes fundamentales de la teoría.

El estudio de los fluidos, como parte de la física, ha seguido un camino semejante lleno de obstáculos salvados, de anécdotas pintorescas, de errores patéticos, de experimentos notables y de teorías ingenuas. Cada faceta del proceso desempeñó una parte importante para alcanzar el nivel que ahora tiene. En la dinámica de fluidos la dificultad más grande ha radicado en la demostración de los teoremas; una enorme cantidad de resultados experimentales y de fórmulas empíricas esperan ser deducidos de los principios básicos de la teoría. Esto permitiría generalizarlos, arrojando luz sobre otros resultados experimentales aparentemente ajenos e igualmente incomprendidos. No hay ninguna rama de la física que pueda considerarse cerrada y todas son objeto de investigación activa; los fluidos no son una excepción. El problema de la turbulencia, que se menciona más adelante, es uno de los grandes retos de la física teórica.

Para construir un aparato teórico que nos permita entender y explicar el movimiento de los fluidos y de los objetos inmersos en ellos, lo cual observamos todos los días, es necesario introducir tres elementos como punto de partida. El primero es el de los conceptos primitivos de masa, espacio y tiempo, el segundo es el constituido por las cantidades (variables) que usamos para caracterizar y describir a un fluido cualquiera y el tercer elemento es el marco de referencia adecuado para determinar estas variables.

En cuanto a los conceptos básicos las definiciones tal vez dejarán que desear y seguramente el lector podría encontrar otras más adecuadas, pero por ahora no hacen falta. La masa es la cantidad de fluido que medimos con una balanza. El espacio es el escenario que usamos para localizar o ubicar al fluido o a una parte de éste. Imaginamos que existe un punto especial, que llamamos origen, y desde él medimos longitudes con una regla. El tiempo será un parámetro que nos permita ordenar estados diferentes del fluido de acuerdo con su aparición en el experimento; este ordenamiento lo establecemos en relación con el Sol o con un reloj. Si no hay cambios, o estados distintos, el parámetro tiempo desaparecerá de la descripción. Si el fluido presenta comportamiento electromagnético, a los elementos básicos debe agregarse la carga.

El segundo punto es más complicado y tiene que ver con cuántas y cuáles cantidades es necesario disponer para contar con una descripción completa y exhaustiva de un fluido. Esta cuestión, que no está del todo libre de controversia, especialmente cuando se trata de fluidos un tanto exóticos, ha ido resolviéndose a lo largo del tiempo con base en la experiencia. Al quedar enunciadas las leyes en su forma actual se estableció cuántas y cuáles variables, que llamaremos variables dependientes, son las mínimas para caracterizar el estado dinámico de un fluido. Al espacio y al tiempo se les llama variables independientes. Antes de especificar qué variables dependientes se usan para describir a un fluido consideremos ahora el punto que se refiere al marco en el que éstas se definen. Para esto vamos a usar una analogía con la astronomía.

Al observar el cielo en una noche clara, con la ayuda de un telescopio, además de la reverencia que infunde su extensión, profundidad y belleza, aparece la duda por saber en qué dirección fijar el instrumento. Si lo que queremos es llevar a cabo una observación sistemática podríamos escoger entre dos posibilidades: una, enfocar un objeto celeste y seguirlo en su trayectoria. Una vez determinada ésta, repetir el proceso con un segundo objeto y así sucesivamente hasta tener una muestra representativa del movimiento de los objetos más brillantes o más azules o lo que sea; la segunda posibilidad consiste en dejar fijo el telescopio, como una ventana al firmamento, y observar los objetos que cruzan el campo visual, determinando su brillo, color, velocidad o belleza. Posteriormente, cambiar la dirección del telescopio e iniciar de nuevo el proceso y, como en el caso anterior, obtener un muestreo de los objetos celestes y de su comportamiento.

Al primer procedimiento se le conoce como descripción lagrangiana, en memoria de Louis Lagrange, uno de los grandes genios de su tiempo, quien dio a la mecánica de Newton una estructura matemática que lo menos que puede decirse es que su elegante belleza iguala su generalidad. La segunda opción es la descripción euleriana, llamada así en honor a Leonhard Euler, el más prolífico matemático en su época, quien formuló la primera teoría de los fluidos; parte de ella se mantiene en su forma original hasta la fecha.

Estas dos descripciones son usadas en física indistintamente, dependiendo de las circunstancias. Como herramienta conceptual, sin embargo, la formulación euleriana conduce a lo que se llama una teoría de campo, esquema que se emplea en la mayoría de las teorías modernas de la física.

Partir de una descripción lagrangiana supone identificar a una partícula de fluido, considerada como un pequeñísimo volumen, y aplicarle las leyes de la mecánica. Si bien es difícil establecer esta identificación en la práctica, conceptualmente es mucho más atractiva la idea de aplicar los principios de la física a un pedazo de materia que se mueve, manteniendo su identidad como sistema, que aplicarlos a un punto por el que van pasando distintas partes del fluido. En los textos modernos que tratan de este tema se hace precisamente esto; se empieza con una descripción lagrangiana y, una vez introducidos los principios e hipótesis físicas necesarias, se traduce al lenguaje euleriano, usando el diccionario (matemático) apropiado que toda lengua merece.

La formulación euleriana, en la que vamos observando diferentes puntos del espacio y estudiamos lo que ahí sucede al transcurrir el tiempo, da lugar a una teoría de campos. La siguiente idea ilustra el contenido de la frase anterior. En cada punto se hallan definidos ciertos atributos físicos del fluido, digamos densidad y velocidad. De un sitio a otro las propiedades cambian de valor, como en la imagen de un paisaje varían las tonalidades de azul o de verde. Además, con el paso del tiempo las propiedades van cambiando, al igual que sucede en los cambios de las estaciones, cuando una planta nace, crece, florece y muere. Las causas para que cada uno de los cambios se dé pueden ser diversas y lejanas; las apreciamos al estudiar no un sólo punto sino muchos, todos, si es posible.

Finalmente, para concluir con los preparativos que nos permitan entrar en el tema, vamos a introducir las variables dependientes, los campos, que nos facilitan la descripción de diversos procesos y la discusión de los principios subyacentes. Dividimos en dos clases a estas variables, los campos escalares y los campos vectoriales.

Los campos escalares son relativamente sencillos y los conocemos por la práctica que adquirimos al habitar nuestro planeta. Su especificación en cada punto está dada por un número de acuerdo con una escala universalmente aceptada. Una gráfica o una tabla de datos correspondientes cada uno a puntos distintos, nos da toda la información espacial del campo. Si éste cambia con el tiempo se necesita una tabla para cada tiempo. Los campos escalares usuales son la densidad, la temperatura y la presión, que representamos por r, T y p, respectivamente.

La densidad nos da una medida relativa entre masa y volumen, es decir, entre la cantidad de materia y el espacio que ocupa, y es una propiedad más o menos familiar. El oro es más denso que el merengue y éste más denso que el aire, todos lo intuimos.

Es importante hacer notar que la densidad es una propiedad intensiva; es decir, no depende de la cantidad. Por ejemplo, las densidades de un anillo y de un lingote, los dos de plata, son iguales, como lo es su color. Definida como el cociente de la masa, que medimos con una balanza, y el volumen, que medimos con... ingenio, la densidad es una propiedad que no depende de la forma del material, pero sí de la temperatura y la presión (no definidas aún, pero cuyo significado sospechamos). Sus dimensiones son, obviamente, las del cociente masa/volumen. Las unidades correspondientes son, por ejemplo, toneladas/litro, kilogramo/galón, miligramo/kilómetro cúbico, etc. La convención usual es el gramo/centímetro cúbico, gr/cm³ (recordemos que 1 litro = 1 000 cm³ ). La tabla siguiente ilustra los valores de la densidad para algunos objetos.

|

|

|

|

Material

|

Densidad (gr/cm3)

|

|

|

|

|

Hoyo negro

|

~ 1018

|

|

Núcleo atómico

|

~ 1014

|

|

Centro del Sol

|

~ 160 000

|

|

Otro sólido

|

19.3

|

|

Centro de la Tierra

|

~ 12

|

|

Agua

|

1

|

|

Hidrógeno líquido

|

0.07

|

|

Aire ambiente

|

0.0012

|

|

Aire a 300 km de altura

|

~ 10-14

|

|

|

|

| ~ aproximadamante | |

La temperatura, otra noción familiar, es un concepto primitivo que no podemos construir en términos de masa, espacio y tiempo en una teoría macroscópica, pero que está asociado a la idea intuitiva del grado de calentamiento de un cuerpo. Aquí nos contentaremos (indignando quizá a más de uno) con definirla como la propiedad que medimos por medio de un termómetro, instrumento que todos conocemos en alguna versión y que hemos usado alguna vez, posiblemente para evitar ir a la escuela. La escala tiene por unidades a los grados Kelvin (º K) y se conoce como la escala absoluta de temperatura; cada º K es equivalente a un º C. De manera que la escala Celsius, que se usa para asignar temperaturas al consomé de pollo o a un niño resfriado, marca las mismas diferencias de temperatura que la escala absoluta, con la peculiaridad de que la mínima temperatura que es posible alcanzar en la naturaleza es de 0º K (= -273.15º C). En el capítulo VI regresaremos a esta singular ley de la naturaleza.

El otro campo escalar que usaremos es la presión y, como se dijo en la sección II. 1, está definida como la fuerza normal que actúa sobre un área dada. Si la misma fuerza normal actúa sobre dos áreas distintas, la presión es menor sobre el área mayor. Como ilustración imaginemos un objeto cuyo peso es suficiente como para que al ponerlo encima de un huevo éste se aplaste sin remedio. Siempre podemos poner suficientes huevos como para que el peso se reparta entre todos, de modo que la fuerza que recibe cada uno no exceda su "factor de aplastamiento". Al distribuirse la fuerza sobre un área mayor, la presión es menor. (figura II.4.)

Figura II. 4. Presión: fuerza repartida en un área.

Por eso los cuchillos cortan, los picahielos pican y las palas palean con la eficiencia que lo hacen; ni se diga si además el usuario sabe emplearlos.

Las dimensiones de presión son de fuerza/área y las unidades de uso más común son el pascal (Pa), las atmósferas (atm) y los milímetros de mercurio (mm-Hg); la equivalencia entre éstas es: 1 atm = 760 mmHg = 101,352 Pa. La presión de una atmósfera es igual al peso que una columna de mercurio de 76 cm de altura ejerce sobre un cm², al nivel del mar. Es la misma que ejerce toda la columna de aire arriba de nuestra cabeza. Esto lo demostró Evangelista Torricelli, discípulo predilecto y último de Galileo, usando el sencillo y convincente dispositivo que aparece en la figura II. 5.

Figura II. 5. Tubo de Torricelli para determinar la presión atmosférica.

Un efecto semejante se observa con el agua, excepto que la columna es ¡de más de 10 m de altura!; por eso es más sensato usar mercurio, pues siendo metal se mantiene líquido a temperatura ambiente. Curiosamente, fue René Descartes, filósofo y matemático del siglo XVII, quien sugirió a Blaise Pascal el experimento para determinar la forma en que cambia la presión atmosférica con la altura. El joven genio construyó entonces un barómetro, como el de la figura II. 5, pero usó vino tinto en lugar del mercurio, ¡en una columna de 14 metros! Debió ser una experiencia memorable...

En el caso de los campos vectoriales las cosas son un poco más complicadas e interesantes, como las personas. Los vectores requieren para su especificación de algo más que un número: reclaman dirección. La velocidad es un ejemplo característico, ya que no es suficiente dar un número, su magnitud, como 20 km/h; hace falta agregar la información que establece en forma unívoca la dirección en la que se mueve el objeto en cuestión. En cada punto y a cada tiempo es preciso dar tres datos, como por ejemplo la magnitud (el tamaño de a flecha que representa al vector) y dos ángulos.

Convencionalmente se usan los ángulos q y f, definidos geométricamente como se ilustra en la figura II. 6. En ésta, las líneas (ejes) x, y, z son mutuamente perpendiculares y al sistema de coordenadas así definido se le llama cartesiano, en honor a Descartes, a pesar de no haber sido quien lo definió por primera vez.

Figura II. 6. Sistema de ejes cartesianos.

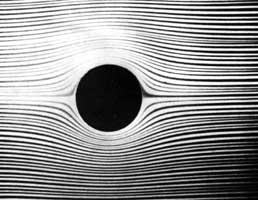

Cada vector es entonces representado por una tema de números que nos da, en el punto e instante correspondientes, la magnitud y orientación locales del campo. Una representación frecuente de un campo vectorial es a través de sus línea de campo, que para el caso de la velocidad en un fluido se llaman líneas de corriente o de flujo. En cada punto de éstas el vector velocidad (cada flecha) es tangente. En donde las líneas de corriente tienden a juntarse la velocidad es mayor que en aquellas donde parecen separarse. Si consideramos flujos en dos dimensiones, como el flujo de una película delgada encima de una superficie, sólo necesitamos dos cantidades, la magnitud y el ángulo con respecto a una dirección; esta última la escogemos con base en algún capricho o conveniencia. En la figura II. 7 se ilustran estas curvas.

Figura II. 7. Flujo uniforme y lento alrededor de un cilindro circular. Nótese que es (casi) imposible distinguir la dirección del flujo.

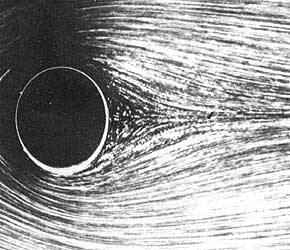

La velocidad, instantánea y local, la definimos como el cociente de la distancia recorrida y el intervalo de tiempo que le toma recorrerla. La velocidad así definida puede cambiar de un punto a otro, o en un mismo punto con el paso del tiempo. Los intervalos de tiempo que corresponderían a esta definición los supondremos tan pequeños como sea posible medirlos en un experimento. En la práctica, lo que se acostumbra hacer es suspender en el fluido partículas reflectoras de luz (hojuelas de aluminio) que al ser iluminadas son captadas por una cámara; la exposición debe ser tan breve como para que las trazas dejadas en la película sean segmentos rectos. El tiempo de exposición es el intervalo de tiempo y la longitud de la traza es la distancia recorrida. La hipótesis implícita es que las partículas suspendidas en el fluido se mueven con éste sin alterar el flujo, de modo que las fotografías nos revelan las líneas de corriente y las velocidades (Figura II. 8).

Figura II. 8. Visualización, por medio de trazadores, de flujo alrededor de un cilindro circular. La velocidad del flujo es mayor que en la figura II. 7.

La fotografía muestra el flujo alrededor de un cilindro, como en la figura anterior; la diferencia estriba en que en este caso la velocidad con la que llega el fluido (de derecha a izquierda) es mucho mayor.

Esta técnica de visualización, introducida a principios de siglo, es hoy en día un elaborado arreglo experimental en el que intervienen todos los adelantos tecnológicos en óptica, electrónica, computación y diseño mecánico. El procesado numérico de imágenes y datos, logrados a partir del análisis de luz láser, dispersada por esferas de poliestireno de una micra de diámetro suspendidas en el fluido, nos permite estudiar minuciosamente flujos que hace unas décadas no se imaginaban, en particular los flujos turbulentos, caóticos y complejos, que discutiremos en el capítulo V.